Мне очень часто приходиться иметь дело с этим. Поделюсь своим опытом:

В Linux уже установлена специальная программа, - wget. Она служит загрузчиком разных файлов из сети (картинок, текст, программ и т.д). Так же её можно использовать для скачивания сайта целиком.

На примере сайта "https://unixhow.com/"

В терминале вводим команду (учитывайте регистр букв), либо копируем отсюда:

wget -r -k -l 5 -p -E -nc https://unixhow.com/

Создастся папка «unixhow.com» , и в неё загрузятся все файлы и страницы сайта. Чтобы просмотреть сайт нужно открыть файл «index.html», запуститься главная страница unixhow.com.

Кратко о параметрах в примере:

-r (--recursive) – Включает рекурсивное сканирование всех каталогов сайта, для загрузки на локальный компьютер.

-k (--convert-links) – Преобразование всех ссылок сайта для корректной работы и отображения.

-l (--level=depth) – Максимальное дерево директорий для скачивание, у нас значение 5. Можно установить значение больше, но если сайт с множеством директорий это займет много времени

-p (--page-requisites) – скачать все файлы, которые требуются для отображения страниц((картинки, таблицы стилей CSS)

-E (--html-extension) – Назначить и сохранить все файлы в расширении «html».

-nc (--no-clobber) – параметр для ускорения загрузки. Не перезаписывает файлы, которые уже сказались.

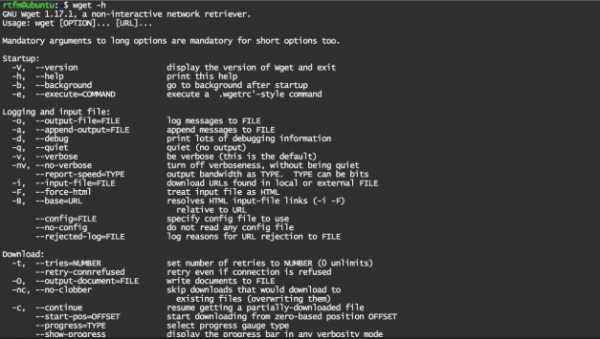

Чтобы узнать больше о параметрах wget:

-h (--help) – покажет весь список доступных команд.